Deep-Learning-Inferenz an der Edge

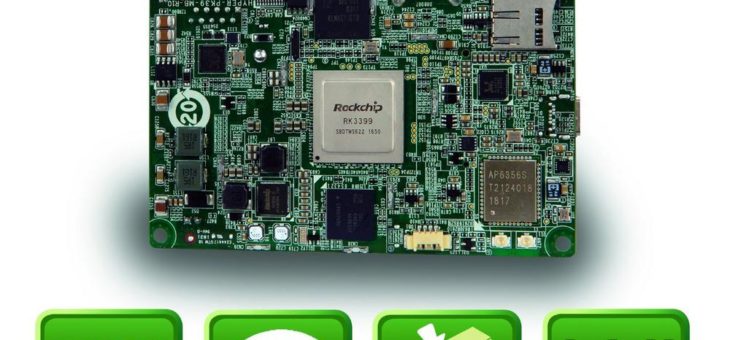

Für die Realisierung von Deep-Learning-Inferenz (DL) an der Edge ist eine flexibel skalierbare Lösung von Nöten, die stromsparend ist und eine geringe Latenzzeit aufweist. Denn an der Edge werden vorwiegend kompakte und passive gekühlte Systeme eingesetzt, die schnelle Entscheidungen ohne Upload in die Cloud treffen. Die neue KI-Beschleunigerkarte Mustang-V100 von ICP Deutschland unterstützt Entwickler beiRead more about Deep-Learning-Inferenz an der Edge[…]